¿Qué tipo de organización podría usar modelos de lenguaje de inteligencia artificial como ChatGPT para engañar a los votantes para que se comporten de maneras específicas?

El 16 de mayo, el senador de EU Josh Hawley le hizo esta pregunta al director ejecutivo de OpenAI, Sam Altman, en una audiencia del Congreso de EU sobre inteligencia artificial. Altman respondió que, de hecho, le preocupaba que algunas personas pudieran usar modelos de lenguaje para manipular, persuadir y participar en interacciones personales con los votantes. Altman no entró en detalles, pero podría tener en mente algo como el escenario que se describe a continuación. Imagine que de pronto los tecnólogos políticos desarrollan una máquina llamada Clogger, una fábrica de campañas políticas en una caja negra. Clogger persigue obsesivamente un solo objetivo: maximizar las posibilidades de que su candidato, la campaña que compra los servicios de Clogger Inc. – gane una elección.

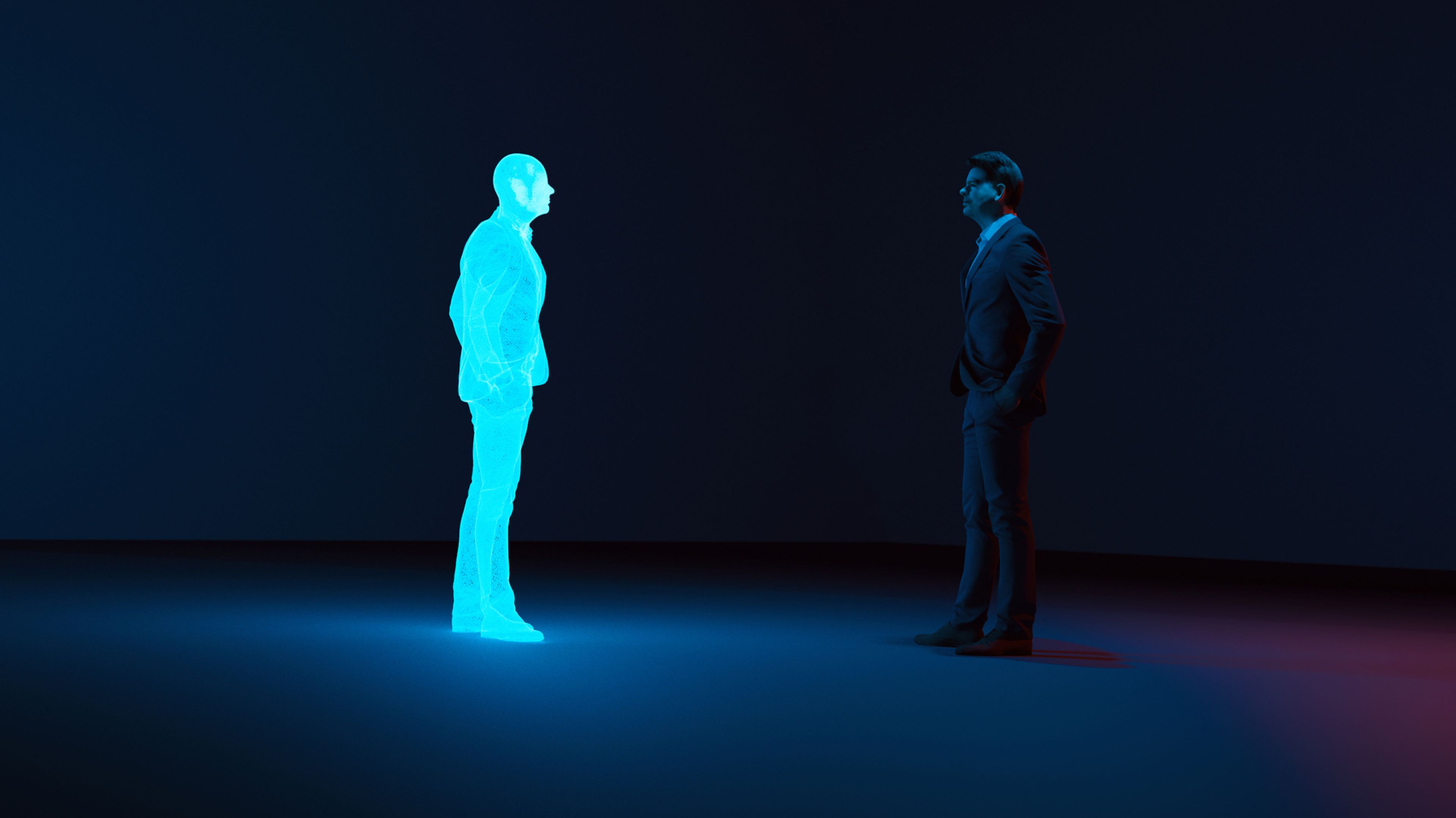

Plataformas como Facebook, Twitter y YouTube utilizan formas de IA para que los usuarios pasen más tiempo en sus sitios web. Pero la IA de Clogger tendría un objetivo diferente: cambiar el comportamiento de votación de las personas.:quality(70)/cloudfront-us-east-1.images.arcpublishing.com/elfinanciero/HXT3WKYVKRC4TFYACFSUXROLYY.jpeg)

Cómo funcionaría Clogger

Como politólogo y jurista , estudiamos la intersección de la tecnología y la democracia. Creemos que algo como Clogger podría usar la automatización para aumentar drásticamente la escala y la eficacia de la manipulación del comportamiento y las técnicas de microfocalización que las campañas políticas han utilizado desde principios de la década de 2000. Nuestro historial de redes sociales para orientarnos con anuncios comerciales y políticos individuales, Clogger lo miraría en detalle a usted, y a cientos de millones de otros votantes, individualmente.

Ofrecería tres pasos más que la manipulación algorítmica de comportamiento de última generación. Primero, su modelo de lenguaje generaría mensajes (textos, redes sociales y correos electrónicos, quizás incluyendo imágenes y videos) hechos a su medida hasta el milímetro. Mientras que los anunciantes programan una cantidad relativamente pequeña de anuncios para todos, los modelos de lenguaje como ChatGPT pueden generar numerosos mensajes exclusivos para cada persona en el transcurso de una campaña.

En segundo lugar, Clogger usaría una técnica llamada aprendizaje por refuerzo para generar una sucesión de mensajes que tendrían cada vez más probabilidades de cambiar su voto. El aprendizaje por refuerzo es un enfoque de prueba y error para el aprendizaje automático, en el que la computadora realiza acciones y obtiene retroalimentación sobre cuál funciona mejor, hasta que aprende cómo lograr un objetivo. Máquinas que pueden jugar al ajedrez, al go y a muchos videojuegos mejor que cualquier ser humano utilizan el aprendizaje por refuerzo.

En tercer lugar, en el transcurso de una campaña, los mensajes de Clogger pueden evolucionar para tener en cuenta sus respuestas a las comunicaciones anteriores de la máquina y lo que ha aprendido acerca de cómo cambiar la opinión de los demás. Clogger podría mantener «conversaciones» dinámicas contigo, y con millones de otras personas, a lo largo del tiempo. Los mensajes de Clogger serían similares a los anuncios que lo siguen en diferentes sitios web y redes sociales.

La naturaleza de la IA.webp)

Vale la pena señalar tres características más. Primero, los mensajes que envía Clogger pueden o no tener contenido político. El único propósito de la máquina es maximizar la proporción de votos. Por lo tanto, probablemente diseñaría estrategias para lograr este objetivo en las que ningún activista humano habría pensado.

Una posibilidad es enviar a los probables votantes de los candidatos de la oposición información sobre las pasiones no políticas que tienen en los deportes o el entretenimiento para enterrar el mensaje político que reciben. Otra posibilidad es el envío de mensajes desconcertantes, por ejemplo, anuncios de incontinencia, sincronizados para coincidir con los mensajes de los oponentes. Y otra es manipular los grupos de amigos de los votantes en las redes sociales para dar la impresión de que sus círculos sociales apoyan a un candidato en particular.

En segundo lugar, Clogger no respeta la verdad. No hay manera de saber lo que es verdadero o falso. Las “alucinaciones” de los sistemas tipo ChatGPT no son un problema para esta máquina, pues su finalidad es cambiar votos, no dar información veraz. En tercer lugar, debido a que es un tipo de inteligencia artificial de caja negra, las personas no tendrían forma de saber qué estrategias utiliza.

¿Democracia o Clogocracia?

Si la campaña presidencial del Partido Republicano de EU desplegara el Clogger en 2024, la campaña demócrata probablemente se vería obligada a responder de la misma manera, tal vez con una máquina similar. Llámalo Dogger. Si los directores de campaña encuentran que estas máquinas son efectivas, la carrera presidencial podría acabar en Clogger vs. Dogger, y el ganador sería el cliente de la máquina más eficiente.

Los politólogos y los expertos tendrían mucho que decir sobre por qué prevaleció una IA u otra, pero probablemente nadie lo sepa realmente. El presidente habrá sido elegido no porque sus propuestas políticas o sus ideas políticas persuadieran a más votantes, sino porque tenía la IA más eficaz. El contenido que ganó la lista habría venido de una IA enfocada solo en ganar, sin ideas políticas propias, y no de candidatos o partidos. En ese sentido tan importante, una máquina habría ganado la elección en lugar de una persona. La elección no sería más democrática incluso si todas las actividades ordinarias de la democracia -los discursos, los anuncios, los mensajes, la votación y el recuento de votos- se hubieran realizado con regularidad.

El presidente electo por AI podría entonces tomar uno de dos caminos. Él o ella podría usar el manto de la elección para seguir las políticas del Partido Republicano o Demócrata. Pero debido a que las ideas partidistas pueden tener poco que ver con la razón por la que la gente votó (a Clogger y Dogger no les importan las opiniones políticas), las acciones del presidente no reflejarían necesariamente la voluntad de los votantes. Los votantes habrían sido manipulados por la IA en lugar de elegir libremente sus líderes políticos y políticas.

Otro camino es que el presidente siga los mensajes, comportamientos y políticas que la máquina predice maximizará sus posibilidades de reelección. En esa dirección, el presidente no tendría una plataforma o agenda específica más que mantener el poder. Lo más probable es que las acciones del presidente, guiadas por Clogger, manipulen a los votantes en lugar de servir a sus intereses genuinos o incluso a la propia ideología del presidente.

Para evitar la Clogocracia

Sería posible evitar la manipulación electoral por parte de IA si todos los candidatos, campañas y consultores renunciaran al uso político de los sistemas. Creemos que esto es poco probable. Si se desarrollan cajas negras políticamente efectivas, la tentación de usarlas será casi irresistible. De hecho, los asesores políticos pueden ver el uso de estas herramientas como requerido por su responsabilidad profesional para ayudar a sus candidatos a ganar. Y una vez que un candidato utiliza una herramienta tan eficaz, difícilmente se puede esperar que los oponentes se resistan desarmándose unilateralmente.

La protección mejorada de la privacidad ayudaría. Clogger se basaría en acceder a grandes cantidades de datos personales para dirigirse a las personas, crear mensajes personalizados para persuadirlas o manipularlas, y rastrearlas y redirigirlas a lo largo de una campaña. Cada parte de esa información que las empresas o los legisladores negaron a la máquina la haría menos efectiva. Otra solución está en los tribunales electorales. Podrían intentar prohibir o regular severamente estas máquinas. Existe un feroz debate sobre si este discurso “replicante” , incluso si es de naturaleza política, puede ser regulado. En países como EU, la defensa extremista de la libertad de expresión lleva a muchos académicos destacados a decir que no.

Pero no hay razón para extender automáticamente la garantía de la libertad de expresión al producto de estas máquinas. Cualquier país puede optar por otorgar derechos a las máquinas, pero esa decisión debe basarse en los desafíos de hoy, no en la suposición errónea de que los autores de las Declaraciones de derechos humanos tenían la intención de que se aplicaran a la IA…

Pero no hay razón para extender automáticamente la garantía de la libertad de expresión al producto de estas máquinas. Cualquier país puede optar por otorgar derechos a las máquinas, pero esa decisión debe basarse en los desafíos de hoy, no en la suposición errónea de que los autores de las Declaraciones de derechos humanos tenían la intención de que se aplicaran a la IA…

Los reguladores de la Ue (Unión Europea) se están moviendo en esa dirección. Se está revisando un proyecto de ley de inteligencia artificial del Parlamento Europeo y se espera que trate los «sistemas de IA creados para influir en los votantes» como de «alto riesgo» y, por lo tanto, sujetos a escrutinio regulatorio. Una medida constitucionalmente más segura, aunque menor, ya adoptada en parte por los reguladores de Internet en la Unión Europea y California , es prohibir que los bots se hagan pasar por personas. Por ejemplo, la regulación puede exigir que los mensajes de campaña vengan con descargos de responsabilidad cuando su contenido sea generado por máquinas en lugar de humanos.

Esto sería como los requisitos de identificación de autoría en los anuncios de campaña electoral: «Producido por el comité electoral del candidato X», pero modificado para reflejar su origen de IA: «Este anuncio generado por IA fue pagado por el candidato X». Una versión más fuerte podría requerir: «El Candidato X le envía este mensaje generado por IA porque Clogger ha predicho que aumentará sus posibilidades de votar por él». Creemos que los votantes merecen saber, como mínimo, cuándo les habla un bot y también deben saber por qué.

La posibilidad de crear un sistema como Clogger muestra que el camino hacia el desempoderamiento colectivo de las sociedades puede no requerir ninguna inteligencia general artificial sobrehumana. Todo lo que se necesita son consultores y activistas entusiastas para tener nuevas herramientas a su disposición, capaces de presionar de manera efectiva los muchos botones de millones de personas.

*Fung es politólogo de la Escuela Kennedy de la Universidad de Harvard. Co-fundó el Proyecto de Política de Transparencia. Lessig es abogado y profesor de derecho en la Universidad de Harvard y fundador de la Fundación Creative Commons. Publicado en The Conversation

Los comentarios están cerrados.